https://sputnikportal.rs/20230720/upozorio-sam-vas-i-niste-me-slusali-tvorac-terminatora-o-vestackoj-inteligenciji-1158837733.html

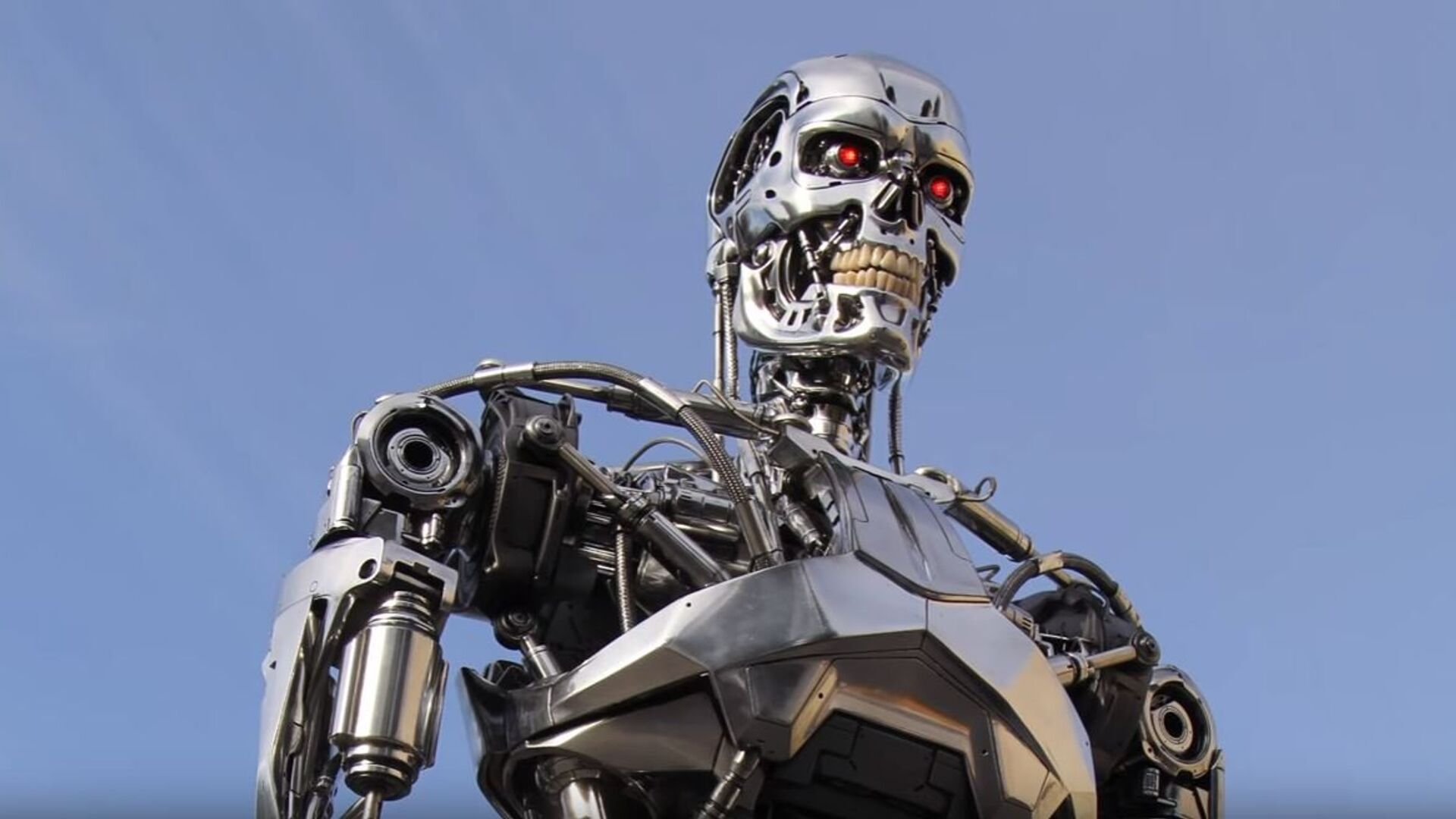

„Упозорио сам вас и нисте ме слушали“: Творац Терминатора о вештачкој интелигенцији

„Упозорио сам вас и нисте ме слушали“: Творац Терминатора о вештачкој интелигенцији

Sputnik Србија

Канадски режисер Џејмс Камерон рекао је да је његов научно фантастични блокбастер „Терминатор“ из 1984. године требало да послужи као упозорење на опасности... 20.07.2023, Sputnik Србија

2023-07-20T10:18+0200

2023-07-20T10:18+0200

2023-07-20T10:18+0200

друштво

друштво

вештачка интелигенција

терминатор

нуклеарни рат

https://cdn1.img.sputnikportal.rs/img/110649/95/1106499559_58:0:1224:656_1920x0_80_0_0_89959772e271e0fa02f54877b77efdd2.jpg

Говорећи за Си-Ти-Ви Њуз у уторак, награђивани филмски стваралац упитан је да ли верује да би вештачка интелигенција једног дана могла да доведе до „изумирања човечанства“, што је страх који деле чак и неки лидери те индустрије.Камерон је даље упозорио да је „наоружавање АИ највећа опасност“.„Мислим да ћемо ући у еквивалент трке у нуклеарном наоружању са вештачком интелигенцијом. А ако га ми не изградимо, други ће га сигурно изградити, а онда ће то ескалирати”, навео је он.У случају да се вештачка интелигенција примени на бојном пољу, компјутери би се могли кретати тако брзо да људи више неће моћи да посредују, рекао је чувени режисер, тврдећи да таква технологија неће оставити времена за мировне преговоре или примирје.Славни филмски стваралац раније је давао слична упозорења, рекавши да, иако АИ може бити прилично сјајан, то би такође могло буквално бити смак света. Чак је отишао толико далеко да је рекао да је вештачка интелигенција могла да преузме свет и да већ манипулише њиме, али ми једноставно не знамо, спекулишући да би компјутери са разумом имали потпуну контролу над свим медијима и свиме.Иако технологија тек треба да постигне светску доминацију, неки водећи стручњаци су такође звучали забринуто у вези са вештачком интелигенцијом. Раније ове године, гиганти вештачке интелигенције, укључујући ОпенАИ и Гуглов Дип Мајнд, придружили су се академицима, законодавцима и предузетницима да издају саопштење којим би позвали на ублажавање „ризика од изумирања од вештачке интелигенције“, рекавши да би то требало да буде „глобални приоритет заједно са другим ризицима на друштвеном нивоу као што су пандемије и нуклеарни рат“.У сличном отвореном писму објављеном прошлог марта позива се на шестомесечну паузу у обуци моћних система вештачке интелигенције, рекавши да их „треба развити тек када будемо уверени да ће њихови ефекти бити позитивни и да ће се њиховим ризицима моћи управљати“. У изјави коју је потписало више од 1.000 стручњака и руководилаца – укључујући Илона Маска и суоснивача Епла Стива Вознијака – упозорава се да би вештачка интелигенција могла да представља „дубоке ризике за друштво и човечанство“.

Sputnik Србија

feedback.rs@sputniknews.com

+74956456601

MIA „Rossiya Segodnya“

2023

Sputnik Србија

feedback.rs@sputniknews.com

+74956456601

MIA „Rossiya Segodnya“

Вести

sr_RS

Sputnik Србија

feedback.rs@sputniknews.com

+74956456601

MIA „Rossiya Segodnya“

Sputnik Србија

feedback.rs@sputniknews.com

+74956456601

MIA „Rossiya Segodnya“

друштво, вештачка интелигенција, терминатор, нуклеарни рат

друштво, вештачка интелигенција, терминатор, нуклеарни рат

„Упозорио сам вас и нисте ме слушали“: Творац Терминатора о вештачкој интелигенцији

Канадски режисер Џејмс Камерон рекао је да је његов научно фантастични блокбастер „Терминатор“ из 1984. године требало да послужи као упозорење на опасности вештачке интелигенције, те да би „наоружавање“ технологије у настајању могло имати катастрофалне последице.

Говорећи за Си-Ти-Ви Њуз у уторак, награђивани филмски стваралац упитан је да ли верује да би вештачка интелигенција једног дана могла да доведе до „изумирања човечанства“, што је страх који деле чак и неки лидери те индустрије.

„Апсолутно делим њихову забринутост. Ја сам вас упозорио 1984. године, и нисте ме слушали“, рекао је он мислећи на његов филм „Терминатор“ који прати кибернетичког убицу ког је креирао интелигентни суперкомпјутер познат као Скајнет.

Камерон је даље упозорио да је „наоружавање АИ највећа опасност“.

„Мислим да ћемо ући у еквивалент трке у нуклеарном наоружању са вештачком интелигенцијом. А ако га ми не изградимо, други ће га сигурно изградити, а онда ће то ескалирати”, навео је он.

У случају да се вештачка интелигенција примени на бојном пољу, компјутери би се могли кретати тако брзо да људи више неће моћи да посредују, рекао је чувени режисер, тврдећи да таква технологија неће оставити времена за мировне преговоре или примирје.

„Када имате посла са таквим потенцијалом да он ескалира у нуклеарни рат, деескалација је главни циљ. Потребан је тај тајм аут – али да ли ће то учинити? АИ неће“, наставио је Камерон.

Славни филмски стваралац раније је давао слична упозорења, рекавши да, иако АИ може бити прилично сјајан, то би такође могло буквално бити смак света. Чак је отишао толико далеко да је рекао да је вештачка интелигенција могла да преузме свет и да већ манипулише њиме, али ми једноставно не знамо, спекулишући да би компјутери са разумом имали потпуну контролу над свим медијима и свиме.

Иако технологија тек треба да постигне светску доминацију, неки водећи стручњаци су такође звучали забринуто у вези са вештачком интелигенцијом. Раније ове године, гиганти вештачке интелигенције, укључујући ОпенАИ и Гуглов Дип Мајнд, придружили су се академицима, законодавцима и предузетницима да издају саопштење којим би позвали на ублажавање „ризика од изумирања од вештачке интелигенције“, рекавши да би то требало да буде „глобални приоритет заједно са другим ризицима на друштвеном нивоу као што су пандемије и нуклеарни рат“.

У сличном отвореном писму објављеном прошлог марта позива се на шестомесечну паузу у обуци моћних система вештачке интелигенције, рекавши да их „треба развити тек када будемо уверени да ће њихови ефекти бити позитивни и да ће се њиховим ризицима моћи управљати“. У изјави коју је потписало више од 1.000 стручњака и руководилаца – укључујући Илона Маска и суоснивача Епла Стива Вознијака – упозорава се да би вештачка интелигенција могла да представља „дубоке ризике за друштво и човечанство“.